本文将从四个方面详细阐述当我们在使用AI模型时,可能会遭遇模型当前过载的情况。这时我们可以尝试重新发送请求或联系OpenAI的帮助中心,如果错误仍然存在,请在消息中包含请求ID以供更好地协助解决问题。

当我们在使用AI模型进行任务处理时,有时可能会遇到“模型当前过载”的错误。这个错误的意思是说,我们的请求已经被服务器通过了,但是由于当前已经发送出了过多的请求,服务器可能无法及时的响应我们的请求。

造成这个现象的原因是,当模型面临大量请求时,服务器资源可能会迅速耗尽,导致服务器响应时间变慢、甚至无响应。即使是具有极高智能的AI模型也会有这个问题,因为它们的计算资源始终是有限的。

当我们遇到这个问题时,我们可以尝试重新发送请求。如果问题仍然存在,请联系 OpenAI 的帮助中心。如果我们需要联系帮助中心,请在消息中包含请求 ID。这将使 OpenAI 的技术支持团队更方便地协助我们解决问题。

模型过载可能出现的原因有很多,以下几种可能性是比较常见的:

1.突发事件导致了异常请求量,比如在某个时间点,突然有很多用户开始使用模型,超出了服务器的处理能力。

2.系统故障导致了部分计算资源被一项或多项任务占用,使其无法为其他请求提供足够的处理能力。

3.服务器或计算资源的容量达到极限,使得模型无法为更多的请求提供处理服务。

因此,当我们遇到模型过载的现象时,需要综合考虑一些可能的原因,以便更好地解决问题。

面对模型过载的现象,我们有几个策略来应对:

1. 简化请求:如果可能的话,我们可以通过简化请求的方式来减轻服务器负担。比如,我们可以尝试使用更简单的数据集、更少的计算资源,或者使用更少的模型参数。

2. 增加服务器容量:如果我们自己有服务器,我们可以考虑增加服务器容量。如果使用的是第三方服务,我们可以向服务提供商询问其是否支持增加计算资源。

3. 调整模型参数:我们可以通过调整模型参数,来让模型更高效地处理请求。比如,我们可以调整模型的器、学习速率等参数,来使模型更快地收敛。

4. 使用分布式计算:分布式计算可以将计算负载分散到多台计算机上。这对于处理大量请求非常有用。

总之,我们应该根据实际情况,采取最恰当的策略。

除了以上提到的应对策略,我们还可以从以下三个方面来避免模型过载的现象:

1. 避免请求暴增:如果我们预计流量将会突然增加,我们应该提前准备。我们可以使用负载测试工具来估计服务的处理能力,以便更好地应对流量攀升。

2. 数据集管理:我们应该根据实际情况选择数据集。如果数据集过大,我们可以考虑对其进行划分,以便更好地管理。在进行模型训练时,我们应该尽量避免使用冗余数据,以减少计算开销。

3. 模型训练:我们可以通过对模型进行,来提高模型的性能。比如,我们可以使用更高效的训练算法、更复杂的模型或者更好的硬件设备,来提高模型训练速度。

当我们在使用 AI 模型时,如果遇到了“该模型当前过载”的错误信息,我们应该采取相应的应对措施。我们可以采用以上几种方法来缓解模型过载的现象。除此之外,我们还可以从源头上避免模型过载。总之,我们应该根据实际情况,选择最恰当的方法来解决问题。

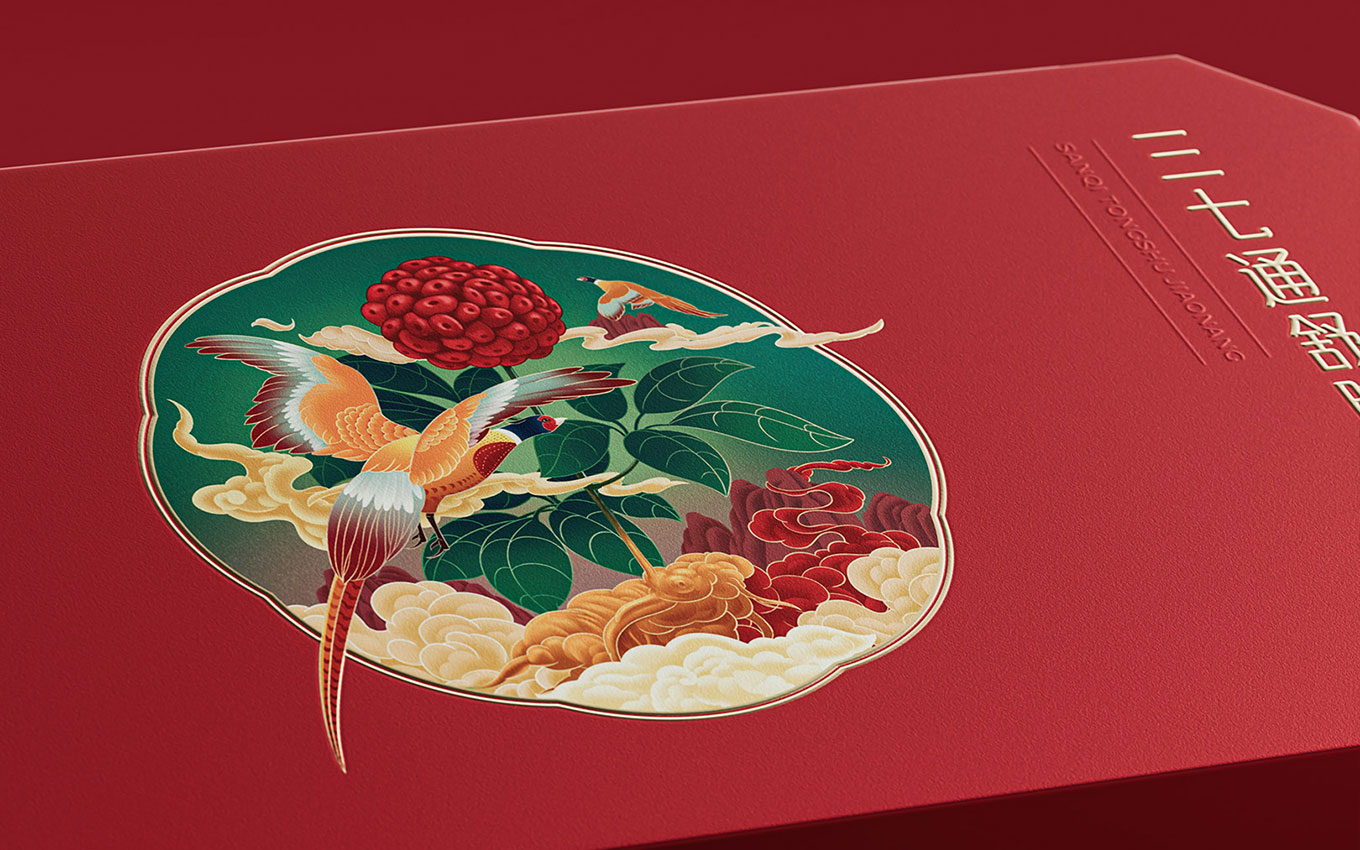

以上米的包装精彩介绍完,接下来我们一起欣赏上海vi设计公司部分案例:

米的包装配图为上海包装设计公司作品

米的包装配图为上海包装设计公司作品

本文关键词:米的包装